生成式AI专家许冰接受《联合早报》访问时说,当前的深伪技术完全可以让诈骗团伙根据需要,制作出虚假内容。“鉴别技术远远落后于生成技术,准确率也不尽如人意,我对生成技术引发的犯罪问题也是比较悲观的。”

在马来西亚去年的六州选举中,被称为最美候选人的马国民主联合阵线(MUDA)党员林慧娴,过去两三年常常收到陌生男子的大量骚扰和威胁短信,不是要她以身相许,就是要她立即还钱。

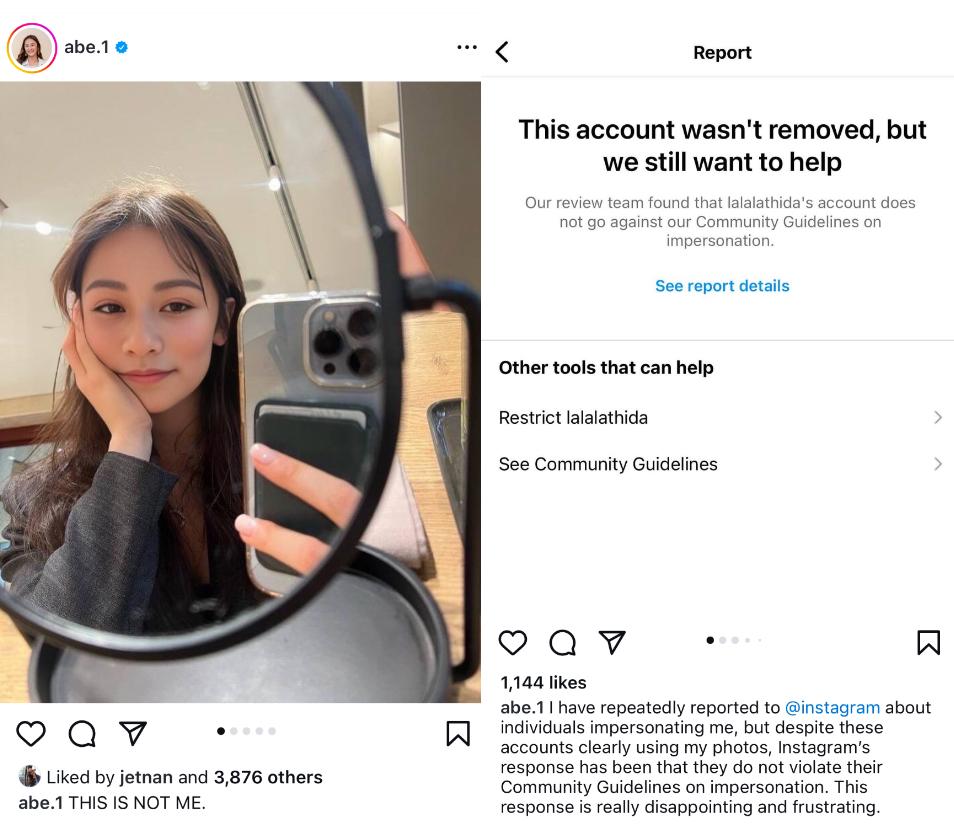

28岁的林慧娴是一名环保分子,也是活跃的Instagram用户,有逾10万追随者。然而,频频在社交媒体分享生活动态给她带来困扰,她相信有诈骗团伙盗用她的个人信息行骗。

林慧娴告诉《联合早报》:“最近这种情况越来越严重,我每天会收到10到20条威胁短信,有些甚至说要飞来马来西亚找我和家人算账。”

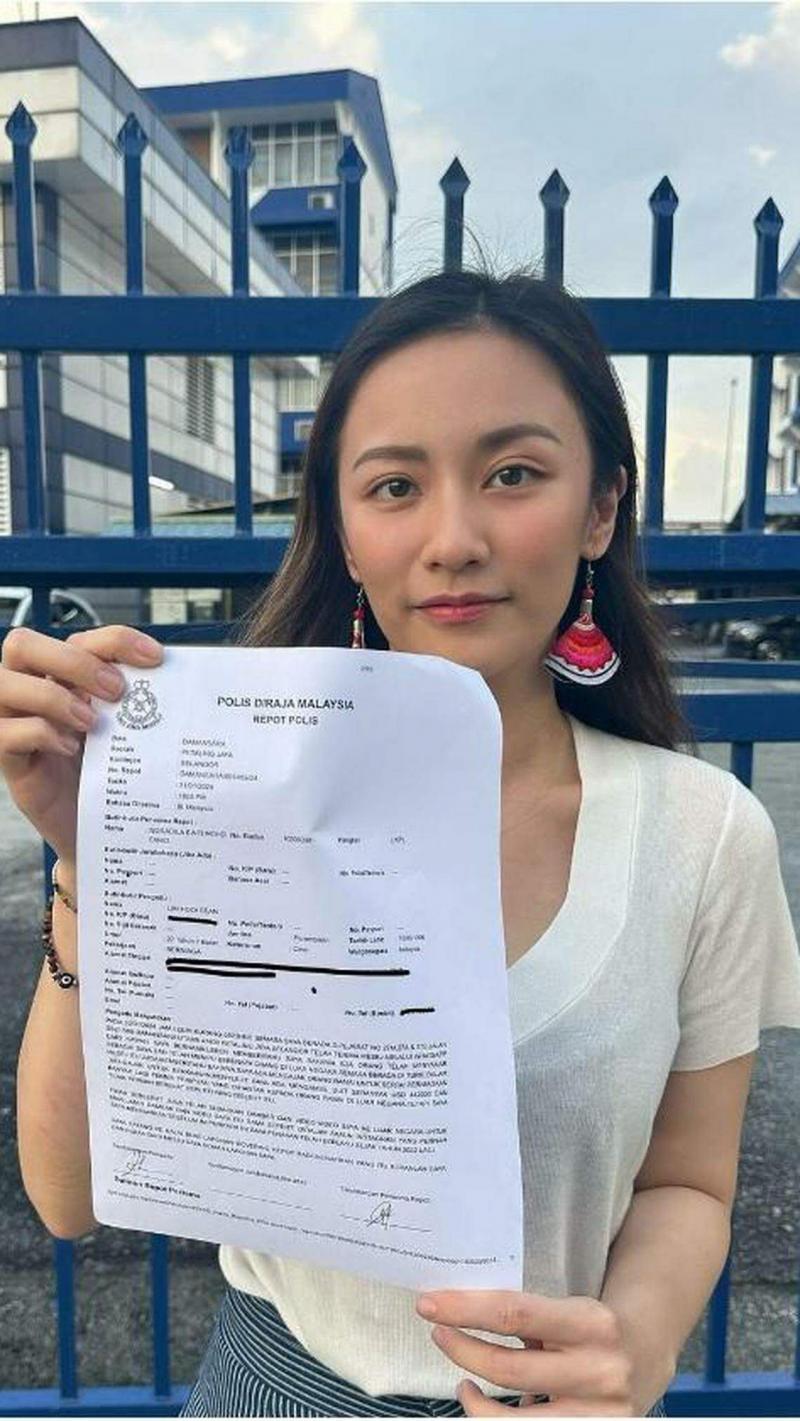

为了自证清白,她1月31日向警方报案,在社媒公开报案信,也数次在社媒发文澄清,但情况没有改善。

记者根据林慧娴提供的短信截图,联系上几名声称被林慧娴诈骗的受害男子。

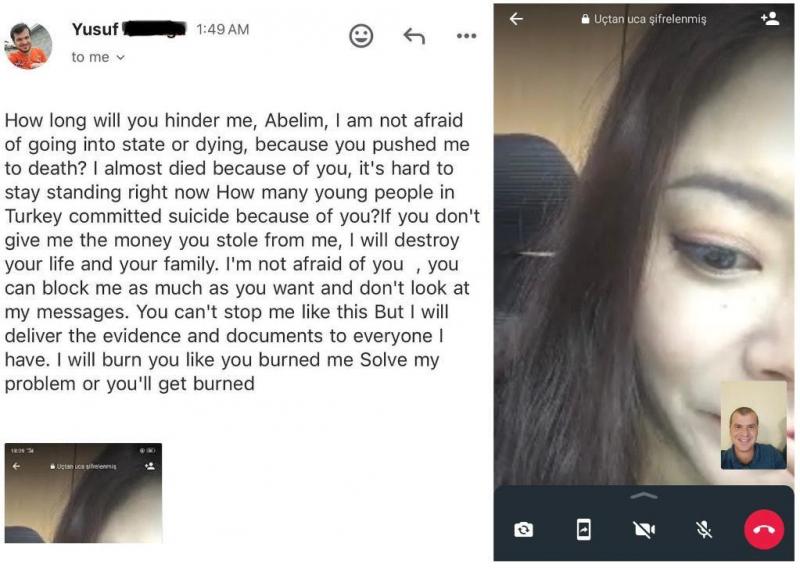

土耳其男子尤索夫(29岁)受访时说,2022年12月,一名自称“Li Chu Xue”的女子以误发短信的方式与他建立联系,然后对他发动甜蜜攻势,他与对方展开长达一年的网恋。期间,对方多次以“要存更多钱才能结婚”为由,游说他进行加密货币交易,最后他被骗了9万1000美元(约12万2000新元)。

尤索夫坚信“Li Chu Xue”就是林慧娴。“我与她视频通话四次,画面高清、声音清楚,还有数不清的照片和视频,她的报警声明证明不了什么。”

林慧娴反驳称,自己不曾与尤索夫联系,更没有欺骗对方的钱财。

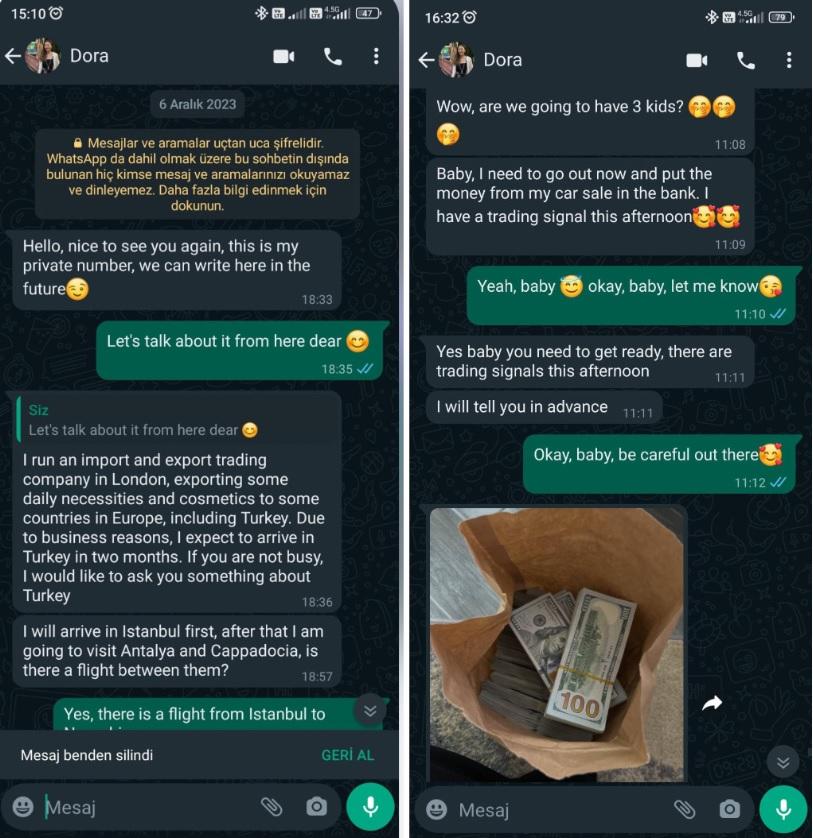

另两名土耳其男子奥兹德米尔(Engin Ozdemir,45岁)和不愿透露全名的塞尔坎(Sercan,32岁)告诉《联合早报》,他们被“Suna”和“Dora”骗了很多钱,他们也相信“Suna”和“Dora”就是林慧娴。他们联系上其他受害者,估计有至少27人。他们已组织起来,向土耳其官方报案,案件现已进入调查阶段。

加拿大男子阿尔丰斯·阮(Alphonse Nguyen,57岁)意识到自己可能陷入“杀猪盘”骗局后,录下与诈骗犯的交谈过程。

阿尔丰斯受访时说,当加密货币交易平台第三次拒绝让他提款后,他有不详的预感,所以要求和网聊了三周的女密友“Olivia Wong”视频通话。“我本就从事电脑相关行业,视频通话开始没多久,我就知道钱被骗走了。她和真正的林慧娴长得有点不像。”

专家:眼见不一定为实 民众须提高警惕

三名土耳其受访者都不相信人工智能(AI)深伪(deepfake)技术能制作出高清视频。奥兹德米尔说:“我在与对方视频通话的两分钟里,甚至看到她脸上的小痘痘。”

生成式AI专家、AI公司HippoML首席执行官兼联合创始人许冰接受《联合早报》访问时说,当前的深伪技术完全可以让诈骗团伙根据需要,制作出带有青春痘、雀斑等脸部细节的虚假内容。

应记者要求,许冰分析了阿尔丰斯录下的视频。他指出,常见摄像头拍下的画面是长方形的,但该视频却是生成式模型默认的正方形,“这显然是有问题的”。

他说:“由于对方很少出现肢体动作,不排除是使用了最初级的换脸技术。”

中国科学技术大学网络空间安全学院副教授周文柏分析阿尔丰斯的视频截屏后说,视频中的人脸缺少细节,纹理过于平滑,光影变化不足,脸部不时会出现明显抖动。“这是用了效果一般的深伪模型生成的典型画面。”

周文柏建议人们要求视频通话的对象转身、遮挡脸部、挤捏鼻子等,来尝试辨别视频中人的真伪。

不过他强调,重要的不是找出明确可用的鉴别方法,而是提高警戒心。“若没有保持警戒的习惯,也就不会想到采用那些鉴别办法。”

尽管专家建议人们通过观察视频中人是否符合现实世界的物理规律,例如观察人物轮廓、脸部协调感、眨眼次数等,来辨别真伪,但美国人工智能公司OpenAI今年2月推出的文字生成视频模型Sora,能够更准确地生成符合现实世界物理原理的逼真视频,再次动摇了用眼睛辨别真假的可靠性。

法律赶不上AI深伪

让情况雪上加霜的是,本应与生成技术一同迭代更新的鉴别技术,陷入了发展瓶颈。

新加坡国立大学计算机学院信息系统与分析学教授韩晸弼(Jungpil Hahn)受访时说,现有技术如图像和文字的水印监测工具等,存在一定的操作缺陷,准确率并不高,所以自动监测系统常会出现大量“假阳性”。

韩晸弼说:“这样一来,许多平台只能聘用专业审查员鉴别真伪,但这种方法的成本很高,社媒等在线平台可能无法承担。”

深伪与鉴别,显然是一场你追我赶的技术竞技。

许冰说:“鉴别技术远远落后于生成技术,准确率也不尽如人意,我对生成技术引发的犯罪问题也是比较悲观的。”

专家的担心与悲观其来有自。英国网络验证公司Sumsub今年初发表的《2023年身份欺诈报告》指出,2022年至2023年间,亚太区的深伪事件增加了1530%。由此可见,深伪正成为欺诈团伙的有力犯罪工具。

今年2月,AI教父本吉奥(Yoshua Bengio)与400多名专家和行业高管签署公开信,指深伪技术或危及社会,呼吁加强对深伪技术的监管。

韩晸弼说,各国政府目前制定的法律并不能有效解决深伪犯罪,推动新立法又冗长耗时,不利于即时惩戒网络犯罪行为。

他提议了两种监管方案:一是要求平台主动筛查不良内容,进行屏蔽和删除,但这个方案的操作成本高,不易推动平台落实;二是向平台发出纠正或禁用指令,但这是被动方案,存在时效问题,因为有害内容被撤销前会继续传播,伤害会持续发生。

当AI深伪诈骗颠覆“眼见为实”,专家建议,人们只能时刻保持警惕,做到不轻信、不透露、不转账,并与亲友预设认证密码,以在关键时刻验明“正身”。

AI深伪沦为“杀猪盘”欺诈工具 专家:眼见

AI深伪沦为“杀猪盘”欺诈工具 专家:眼见

普京警告西方:俄已做好核战准备

普京警告西方:俄已做好核战准备

中国批TikTok剥离法案不公 周受资吁美国用

中国批TikTok剥离法案不公 周受资吁美国用

空袭粮食分发中心五人死 以军称击毙哈马斯

空袭粮食分发中心五人死 以军称击毙哈马斯